Mit Algorithmic Bias wird die algorithmische Voreingenommenheit bezeichnet, die Datenwissenschaftler immer wieder vor Herausforderungen stellt. Wir erklären, wie Diskriminierung durch Algorithmen entsteht und welche Lösungsansätze es gibt.

Künstliche Intelligenz in unserem Alltag

Künstliche IntelligenzWas ist Künstliche Intelligenz? Definition Künstliche Intelligenz bzw. KI (auf Englisch: Artificial Intelligence bzw. AI) ist ein Teilgebiet der Informatik. KI soll es dem Computer ermöglichen Aufgaben und Probleme zu lösen, die menschliche Intelligenz benötigen. Des Weiteren befasst sich künstliche Intelligenz mit der Automatisierung von intelligentem Verhalten, dem maschinellen Lernen (Machine Learning) und dem Deep Learning. << zurück zum Glossar (KI) wird auch als artifizielle Intelligenz (AI) bezeichnet. In naher Zukunft sollen Computer ähnlich intellektuelle Fähigkeiten einsetzen, wie sie der Mensch hat. Bereits heute bereichert KI unterschiedliche Bereiche unseres Lebens. Dazu zählen Wirtschaft, Arbeit, Medizin, Mobilität und Kommunikation. Es handelt allerdings sich um schwache KI. Also Systeme, die nur in einem Anwendungsfall gut sind, wie beispielsweise bei Sprachassistenten, Navigationssystemen oder der Google-Suche. Die zum Einsatz kommenden Algorithmen lernen beständig anhand der zur Verfügung stehenden Daten.

Big Data als Futter algorithmischer Systeme

Doch die Entwicklung starker KI geht weiter und so werden Systeme trainiert, unterschiedliche Fähigkeiten miteinander zu kombinieren. Dafür sollen künstliche neuronale Netze geschaffen werden. Big DataDefinition: Was ist Big Data? Big Data stammt aus dem Englischen und bezeichnet riesige Datenmengen. Die Massendaten sind grundsätzlich durch ihre Größe, Schnelllebigkeit, Komplexität und schwache Struktur gekennzeichnet. Der Begriff unterliegt einem kontinuierlichen Wandel – so wird Big Data auch als ein Sammelbegriff für digitale Technologien verwendet. Weiterhin beschreibt Big Data eine Technologie zur Verarbeitung und Auswertung eben jener Daten. ist das Futter der Künstlichen Intelligenz. Auf Grundlage der eingespeisten Datenmassen lernen KI-Systeme (Machine Learning).

Damit können Technologien weiterentwickelt und unser Leben noch mehr erleichtert werden. Allerdings sind wir noch weit davon entfernt den Ergebnissen von Algorithmen blind zu vertrauen. Gerade wenn sich daraus relevante Entscheidungen für ein soziales Umfeld ergeben, steht die Forschung immer wieder vor dem Problem der Diskriminierung. Einzelschicksale können unter Umständen sehr negativ beeinflusst werden.

Menschliche Zukunft von Maschinen bestimmt

In den USA wird KI bereits häufiger als Entscheidungsgrundlage in gesellschaftlichen Bereichen eingesetzt. Beispielsweise bei der Rückfallwahrscheinlichkeiten von Angeklagten in den USA. Ein Algorithmus soll Richtern eine Vorhersage liefern, wie hoch die Wahrscheinlichkeit ist, dass der Angeklagte erneut eine Straftat begeht. Als Futter für diese Wahrscheinlichkeitsrechnung dienen beispielsweise Herkunft des Angeklagten, Alter, finanzielle Lage und Statistiken früherer Kriminalfälle. Es ist fraglich, ob ein solches System zur Gerechtigkeit innerhalb einer Gesellschaft beitragen und Einzelschicksale richtig beurteilen kann.

Wie entsteht algorithmische Voreingenommenheit?

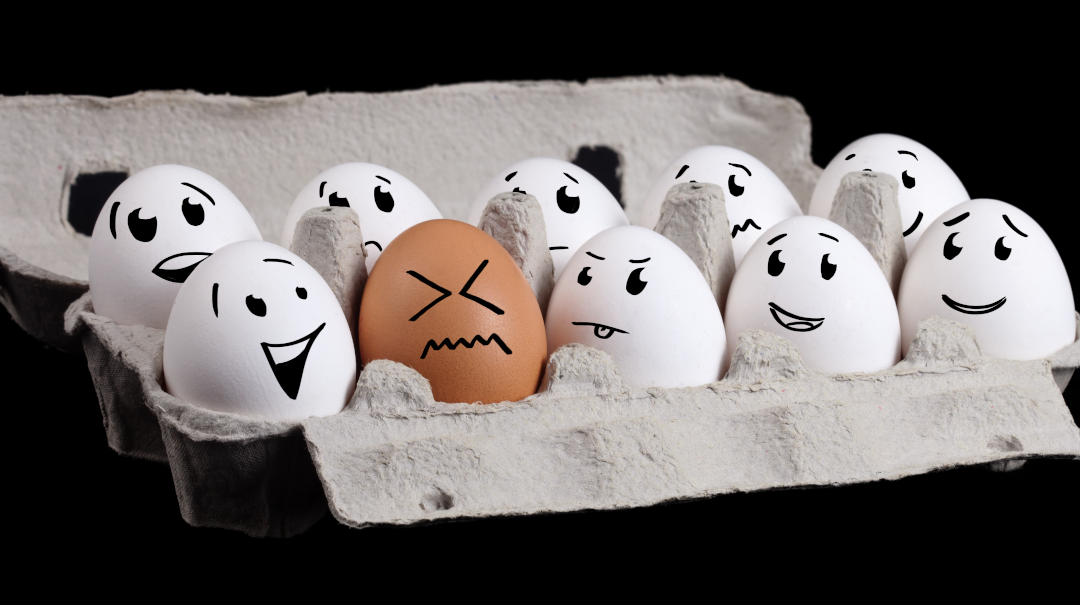

Algorithmic Bias entsteht durch fehlerhafte Daten bzw. deren Verarbeitung. KI-Systeme sind nicht von Gefühlen oder Empathie bestimmt. Somit bewerten sie Sachverhalte objektiv. Die Trainingsdaten, mit denen die Künstliche Intelligenz gefüttert wird, liefert jedoch der Mensch. Der entscheidet anhand seiner eigenen Erfahrungen subjektiv. So kommt es immer wieder zu Verzerrungen und zur Diskriminierung. Diese Verzerrung wird Algorithmic Bias genannt.

In der Statistik wird Bias als Fehler in der Datenerhebung bzw. -verarbeitung bezeichnet. Diese können bewusst (expliziter Bias) oder unbewusst (implizierter Bias) in den Algorithmus einfließen.

Faktoren, aus denen Algorithmic Bias entstehen kann

Eine KI kann nur so gut sein, wie die Menschen, die sie programmiert haben und die Daten, auf denen sie beruht. Eine Verzerrung kann durch folgende Faktoren entstehen:

Technische Voraussetzungen

Die technischen Voreinstellungen an Geräten können Aussagen verzerren. Beispielsweise kann der Sensor eines Gerätes nur auf bestimmte Einflüsse ausgerichtet sein. Darunter fällt auch die Darstellung eines Bildschirms, der Teile eines Inhaltes nicht anzeigt. Wir wissen ja, dass für denjenigen, der schnelle Ergebnisse auf Google sucht, die Seite zwei eigentlich nicht existiert. Wie viele Ergebnisse Seite eins bietet, hängt allerdings von dem jeweiligen Gerät ab.

Verzerrung aufgrund historischer Daten

Die Daten vorangegangener Jahre sind nicht immer repräsentativ, um gegenwärtige Entscheidungen zu treffen: Ein großes Unternehmen setzte ein System ein, das die Vorauswahl von Bewerbern aufgrund deren Anschreiben erleichtern sollte. Das Tool beurteilte Bewerber ungewollt nach Geschlecht. Als Grundlage dienten Mitarbeiterdaten der vorangegangenen zehn Jahren. Da in dieser Zeit hauptsächlich Männer im Unternehmen tätig waren, beurteilte die Software Frauen als weniger geeignet für den Beruf. Obwohl das Geschlecht nicht als Entscheidungskriterium angegeben war. Auch nach Behebung der Fehler interpretierte das Tool den Kontext der Bewerbungen immer wieder fehlerhaft. Daraufhin wurde diese Art der Bewerberauswahl innerhalb des Unternehmens fallen gelassen.

Verzerrung durch fehlende Daten

Kannst du dich an die Anfangszeit von Sprachassistenten erinnern? „Tut mir leid, ich habe Sie nicht verstanden!“ Zeitraubend und kaum zielführend. Grund für das Unverständnis waren fehlende Trainingsdaten. Wurde dem System der bayrische Dialekt vorenthalten, konnte es diesen auch nicht erkennen und somit nicht verstehen. Heute steuern bereits fünfjährige Alexa und bekommen genau den Party-Kracher ins Ohr, den sie sich gewünscht haben. Vielleicht nicht immer zur Freude der Eltern. Das System erkennt unterschiedliche Dialekte und auch nicht ganz sauber ausgesprochene Worte durch selbstlernende Maschinen.

Noch schlimmer fällt die Diskriminierung aus, wenn Systeme beispielsweise nur mit Daten von Menschen mit weißer Hautfarbe angelernt werden, wie dieses kurze Video sehr gut verdeutlicht:

Ein Thema, das aufgrund der aktuellen Debatte um #blacklivesmatter wohl kaum aktueller und wichtiger sein könnte!

Wie kann voreingenommenen Systemen entgegengewirkt werden?

Doch wie kann Algorithmic Bias entgegengewirkt werden? Da Ethikgrundsätze über das Aufgabengebiet von Programmierern herausragen, widmet sich die Bundesregierung dem Thema. Innerhalb der Datenethikkommission wurden Handlungsempfehlungen verfasst. Darin wird beispielsweise geregelt, dass staatliche Entscheidungen, die auf Grund algorithmischer Systeme zustande gekommen sind, transparent und begründbar dargestellt werden müssen. In bestimmten Teilbereichen wie freier Meinungsbildung sollen Algorithmen nicht zum Einsatz kommen.

Die Aussagekraft Künstlicher Intelligenz ist somit nach wie vor durch Menschen zu überprüfen. Besonders, wenn daraus eine Benachteiligung bestimmter Gruppen resultieren kann.

In der heutigen Zeit umgibt uns ausschließlich schwache KI. Eine starke KI ist in der Tat NOCH Zukunftsmusik. Jedoch spricht wenig dagegen, dass es diese geben wird. Doch beispielsweise selbstfahrende Autos, als solche Form einer starken KI, werden von einer Gesellschaft jedoch nur akzeptiert, wenn ethnische Grundsätze eingehalten und kein Einzelschicksal durch einen Algorithmus benachteiligt wird.

Trackbacks/Pingbacks